| Rome University, La Sapienza Chemistry Department Rome, Italy, Europe |

Dr. Giovanni Visco Cenni di statistica di base. Calcoli di regressioni e correlazioni. dicembre 2006 |

Corso di Laurea in Scienze Applicate ai Beni Culturali ed alla Diagnostica per la loro Conservazione |

| previous slide, 42 | next slide, 44 |

Appena qualche slide prima di questa abbiamo visto un esempio di covarianza e correlazione quasi nulla ma con dati che una volta presentati in un semplice grafico risultano ben "correlati" fra loro. Qualche volta una correlazione che non e' lineare puo' essere studiata (scoperta) dopo qualche trasformazione matematica.

La linearizzazione e' possibile quando una funzione di correlazione e' lineare nei parametri anche essendo non lineare nelle variabili (y=a+bx+cx2 oppure y= a+bLog(x)). Ma spesso il mondo reale presenta funzioni di difficile linearizzazione, come y=a*e(-bx) del decadimento radioattivo ma anche alcune non linearizzabili, y=a*e(-bx)+cx sempre un decadimento ma con nun fondo di un emettitore a lungo periodo.

Galileo Galilei di certo non e' stato il primo a studiare la caduta di un grave ma pur facendo nascere con i suoi studi la Metodologia Sperimentale e la Riproducibilita' non aveva la nostra tecnologia. Ecco un link con un doppio significato: ottimo esempio di musealizzazione, descrizione di un opera.

Veramente questo esempio non sarebbe corretto in quanto sappiamo gia' la relazione che lega le due variabili. L'esempio andrebbe bene per la sezione "regressione" ma tornate indietro nel tempo mentre ancora non era nota l'equazione del moto.

Studiamo noi invece la caduta di un grave; prendiamo un sfera di un metallo molto denso, Osmio, installiamo su di un asse verticale una serie di fotocellule, una ogni 50mm, scegliamo un sistema di acquisizione dati con una risoluzione di 1 ms. Facciamo cadere il grave e leggiamo i tempi di attraversamento delle fotocellule (ma non eravamo tornati alla fine del 1500?). Non teniamo conto dell'aria, della latitudine e di tante altre cosette!

| misura n. | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| distanza percorsa (m) | 0.00 | 0.05 | 0.10 | 0.15 | 0.20 | 0.25 | 0.30 | 0.35 | 0.40 | 0.45 | 0.50 | 0.55 | 0.60 |

| tempo (s) | 0.000 | 0.101 | 0.143 | 0.175 | 0.202 | 0.226 | 0.247 | 0.267 | 0.286 | 0.303 | 0.319 | 0.335 | 0.350 |

In 0.45 secondi il grave ha gia' percorso 1 metro. Fermiamo qui l'analisi, avremmo bisogno di tante altre fotocellule e poi stiamo arrivando al limite della risoluzione.

|

non lineare

Dato che la distanza fra le fotocellule e' fissa questo e' un tipico esempio di un sistema con un grado di liberta' in meno, mettiamo percio' la distanza sull'asse X ed il tempo misurato sull'asse Y. Mettiamo anche le barre di errore pari a due volte la risoluzione.

allora linearizziamo Cioe' andiamo a cercare se con qualche trasformazione matematica su una delle due variabili si ottiene una relazione lineare. Nel nostro caso proviamo con x2, cioe' con il quadrato del tempo impiegato dal grave.

Un grosso problema sono le barre di errore sull'asse Y. Si debbono ricavare i valori con la propagazione degli errori tenendo conto dell'equazione usata per linearizzare (anche per l'errore sull'asse X se e' linearizzato). |

Ora che abbiamo visto un esempio di linearizzazione forse e' bene ri-affermare che NON e' un bell'esempio, non trattasi di regressione per cui non sappiamo quale e' la funzione di trasformazione verso la linearita' (e non sappiamo nemmeno se esiste).

Detto questo vediamo come potremmo procedere in un caso incognito di ipotetica correlazione fra due variabili:

Prendiamo l'esempio di prima e proviamo la linearizzazione confrontando Y , Log(Y) , Y2 , eY.

| misura n. | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 |

| X (m) | 0.00 | 0.05 | 0.10 | 0.15 | 0.20 | 0.25 | 0.30 | 0.35 | 0.40 | 0.45 | 0.50 | 0.55 | 0.60 | 0.65 | 0.70 | 0.75 | 0.80 | 0.85 | 0.90 | 0.95 | 1.00 |

| Y (s) | 0.000 | 0.101 | 0.143 | 0.175 | 0.202 | 0.226 | 0.247 | 0.267 | 0.286 | 0.303 | 0.319 | 0.335 | 0.350 | 0.364 | 0.378 | 0.391 | 0.404 | 0.416 | 0.428 | 0.440 | 0.452 |

| Log(Y) (s) | n.a. | -.996 | -.845 | -.757 | -.695 | -.646 | -.607 | -.573 | -.544 | -.519 | -.496 | -.475 | -.456 | -.439 | -.423 | -.408 | -.394 | -.381 | -.369 | -.357 | -.345 |

| Y2 (s) | 0.000 | 0.010 | 0.020 | 0.031 | 0.041 | 0.051 | 0.061 | 0.071 | 0.082 | 0.092 | 0.102 | 0.112 | 0.123 | 0.132 | 0.143 | 0.153 | 0.163 | 0.173 | 0.183 | 0.194 | 0.204 |

| eY (s) | 1.000 | 1.106 | 1.154 | 1.191 | 1.224 | 1.254 | 1.280 | 1.306 | 1.331 | 1.354 | 1.376 | 1.398 | 1.419 | 1.439 | 1.459 | 1.478 | 1.498 | 1.516 | 1.534 | 1.553 | 1.571 |

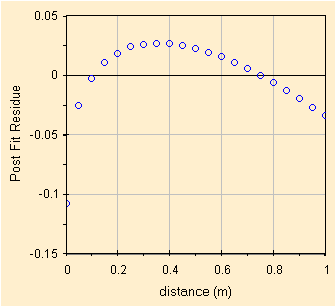

Iniziamo con la variabile Y non trasformata, cioe' il tempo misurato in ms. Di seguito i parametri della correlazione ed il grafico dei residui (con numeri/scala della Y mal scritta). Per il calcolo dei parametri possiamo usare lo spreadsheet CorrelationOLS.123 gia' visto qualche slides prima.

| parameters (estimated with OLS method) |

values |  |

| sample covariance | 0.0363750 | |

| population covariance | 0.0346429 | |

| Pearson sample correlation coefficient | 0.9658713 | |

| square of the Pearson sample corr. coeff. | 0.9329075 | |

| assess of Std Err of Pearson's r | 0.0594238 | |

| variance of residuals | 0.0010407 | |

| residual sum of squares (RSS), sample | 0.0197729 | |

| root mean square deviation (RMSD), sample | 0.0314427 | |

| degrees of freedom | 19 | |

| standard error of the Y estimate | 0.0322596 |

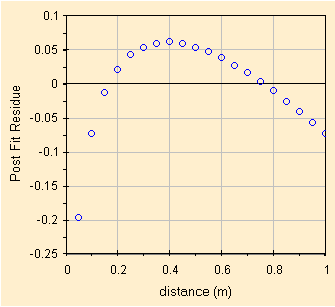

Poi proviamo una linearizzazione trasformando la variabile Y in Log(Y). Chiaramente quando il grave e' fermo, cioe' distanza=0 non possiamo colcolare il Log cosi' abbiamo un punto in meno! Di seguito i parametri della correlazione ed il grafico dei residui.

| parameters (estimated with OLS method) |

values |  |

| sample covariance | 0.0485898 | |

| population covariance | 0.0461603 | |

| Pearson sample correlation coefficient | 0.9313267 | |

| square of the Pearson sample corr. coeff. | 0.8673695 | |

| assess of Std Err of Pearson's r | 0.0858392 | |

| variance of residuals | 0.0043551 | |

| residual sum of squares (RSS), sample | 0.0783925 | |

| root mean square deviation (RMSD), sample | 0.0642333 | |

| degrees of freedom | 18 | |

| standard error of the Y estimate | 0.0659935 |

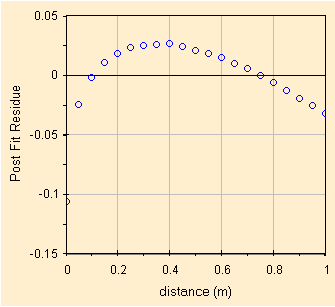

Poi proviamo una linearizzazione trasformando la variabile Y in Y2. Di seguito i parametri della correlazione ed il grafico dei residui.

| parameters (estimated with OLS method) |

values |  |

| sample covariance | 0.0196224 | |

| population covariance | 0.0186880 | |

| Pearson sample correlation coefficient | 0.9999965 | |

| square of the Pearson sample corr. coeff. | 0.9999931 | |

| assess of Std Err of Pearson's r | 0.0006036 | |

| variance of residuals | 0.0000000 | |

| residual sum of squares (RSS), sample | 0.0000006 | |

| root mean square deviation (RMSD), sample | 0.0001664 | |

| degrees of freedom | 19 | |

| standard error of the Y estimate | 0.0001707 |

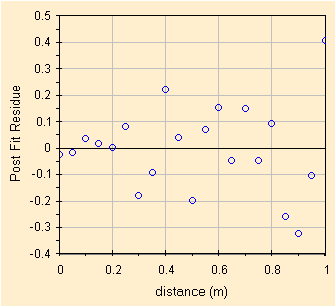

Poi proviamo un'altra linearizzazione questa volta trasformando la variabile Y in eY. Di seguito i parametri della correlazione ed il grafico dei residui.

| parameters (estimated with OLS method) |

values |  |

| sample covariance | 0.0478812 | |

| population covariance | 0.0456012 | |

| Pearson sample correlation coefficient | 0.9808538 | |

| square of the Pearson sample corr. coeff. | 0.9620742 | |

| assess of Std Err of Pearson's r | 0.0446777 | |

| variance of residuals | 0.0009884 | |

| residual sum of squares (RSS), sample | 0.0187796 | |

| root mean square deviation (RMSD), sample | 0.0306427 | |

| degrees of freedom | 19 | |

| standard error of the Y estimate | 0.0314388 |

Confrontando i risultati si nota che la trasformazione dell'asse Y in eY migliora un poco la correlazione ma la miglior linearizzazione si ottiene trasformando Y in Y2 ottenendo un grafico dei residui da manuale (anzi che mostra come gia' ad 1 m si inizia a vedere l'aumento degli errori, forse da parte delle fotocellule).

Per la linearizzazione si possono usare tante funzioni matematiche. In giro per internet c'e' una tabella con alcune funzioni matematiche, e' quella della Prof. Maria Teresa Garetto che nessuno cita mai per il suo Statistica Lezioni ed Esercizi. Leggete la tabella a pag. 55 e se volete il capitolo da pag. 49 a pag. 58. Purtroppo nel testo, interessante, NON ritroviamo nemmeno una volta la parola Validazione, e neanche Residui, ma nemmeno Predizione.

Se avete solo poche coppie di dati e' probabile che riusciate con successo a linearizzarli con tante equazioni diverse. Per 4 punti puo' passare un cerchio, una parabola, un iperbole, una quadratica, etc., specie se i punti sono vicini e soggetti al rumore sperimentale. Per questo la linearizzazione necessita un Gran Numero di punti sperimentali per aver senso. Sapendole usare, le cosidette tecniche di Resampling potebbero aiutare se vi manca qualche punto.

| previous slide | next slide |